Летом 2017 года группа исследователей из Google Brain опубликовала научную работу под названием "Attention Is All You Need", которая навсегда изменила развитие искусственного интеллекта. Эта статья, представленная на конференции Neural Information Processing Systems (NeurIPS), заложила фундамент для всех современных генеративных моделей ИИ - от GPT до LLaMA, BERT и других.

Революционная архитектура

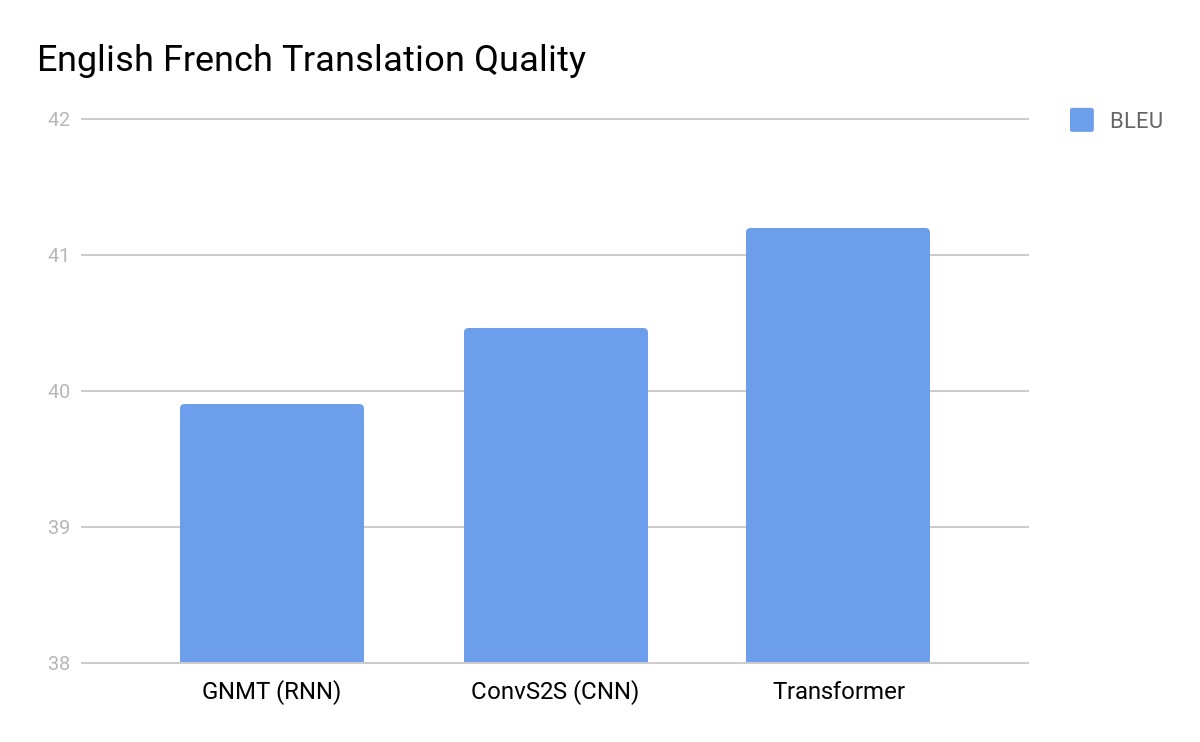

До появления Transformer основой обработки естественного языка были рекуррентные нейронные сети (RNN). Они обрабатывали текст последовательно, слово за словом, что создавало ряд ограничений. RNN плохо справлялись с длинными текстами и не поддавались распараллеливанию.

Исследователи Google Brain предложили принципиально новый подход - полностью отказаться от рекуррентности. Вместо этого модель анализирует все слова предложения одновременно, определяя связи между ними с помощью механизма внимания (attention). Этот механизм позволяет фокусироваться на наиболее важных частях текста.

Неожиданный успех

Изначально даже инженеры Google не осознавали масштаб потенциального влияния своей разработки. Однако после публикации исходного кода архитектура Transformer начала стремительно набирать популярность.

В течение года появились новые модели на основе Transformer:

- BERT от Google улучшил понимание языка и был интегрирован в поисковую систему

- GPT от OpenAI продемонстрировал способность генерировать человекоподобный текст

- ChatGPT, использующий GPT-3.5, произвел революцию в общении человека с ИИ

Универсальная технология

Transformer оказался эффективен не только для работы с текстом. Исследователи успешно применили механизм внимания к другим типам данных - изображениям, музыке, программному коду. Появились модели вроде CLIP и DALL-E, объединяющие понимание текста и изображений.

Гонка за масштабом

Исследования показали, что производительность Transformer-моделей растет пропорционально увеличению количества параметров и объема обучающих данных. Это привело к соревнованию между технологическими гигантами в создании все более крупных моделей. GPT-3 сменился GPT-4, Google представил PaLM с сотнями миллиардов параметров.

Этические вопросы

Широкое распространение генеративного ИИ породило ряд проблем:

- Риски распространения дезинформации

- Вопросы авторских прав

- Возможность создания токсичного контента

- Наличие предвзятости в обучающих данных

Компании-разработчики начали внедрять механизмы контроля и ограничения, но многие вопросы остаются нерешенными.

Transformer продолжает развиваться - появляются новые архитектуры вроде Performer, Longformer и Reformer, направленные на повышение эффективности механизма внимания. Технология, родившаяся как эксперимент в лаборатории Google, изменила наше представление о возможностях искусственного интеллекта и продолжает определять будущее этой области.