27-летняя женщина подала коллективный иск против компании Apple, обвиняя технологического гиганта в отказе от внедрения системы обнаружения материалов сексуального насилия над детьми (CSAM) в облачном сервисе iCloud.

Истица, пожелавшая остаться анонимной, подверглась насилию в младенческом возрасте со стороны родственника, который не только совершал противоправные действия, но и распространял фотографии в интернете. На протяжении многих лет она продолжает получать уведомления от правоохранительных органов о новых случаях обнаружения этих изображений.

В 2021 году Apple анонсировала технологию NeuralHash для выявления CSAM на устройствах пользователей, но позже отказалась от её внедрения после критики со стороны экспертов по кибербезопасности. Эксперты выражали опасения, что данная система может быть использована правительствами для слежки.

В иске утверждается, что компания:

- Не использовала разработанные инструменты защиты

- Недостаточно активно боролась с CSAM по сравнению с другими технологическими компаниями

- Поставила конфиденциальность выше безопасности детей

Коллективный иск представляет интересы около 2680 потенциальных жертв. Общая сумма компенсации может превысить 1,2 миллиарда долларов, поскольку по закону каждая жертва имеет право на минимальную компенсацию в размере 150 000 долларов.

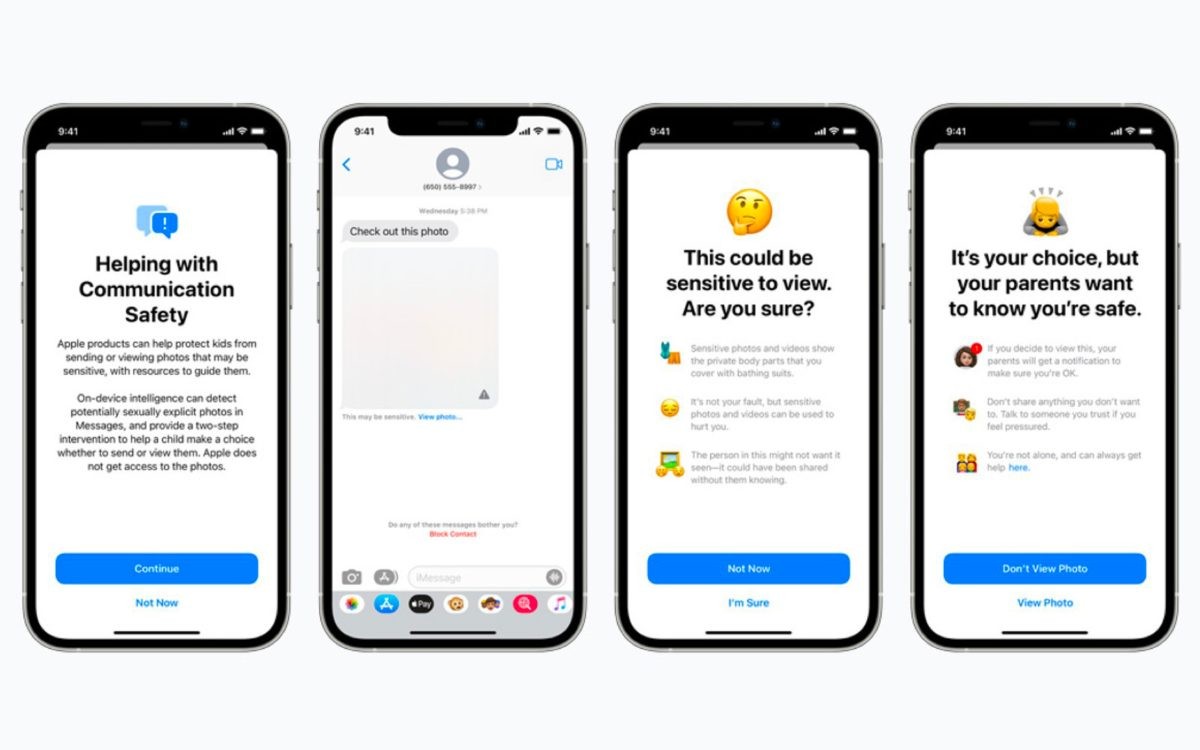

Представитель Apple Фред Сайнс заявил, что компания считает CSAM "отвратительным явлением" и привержена борьбе с такими преступлениями при одновременной защите конфиденциальности пользователей. Он также отметил наличие предупреждений о нежелательном контенте в приложении Messages и инструментов для сообщения о вредоносных материалах.